2021.08.06| Android Authority

Az Apple gyerekbántalmazásra utaló jelekre vadászik mostantól az üzenetek és fotók között.

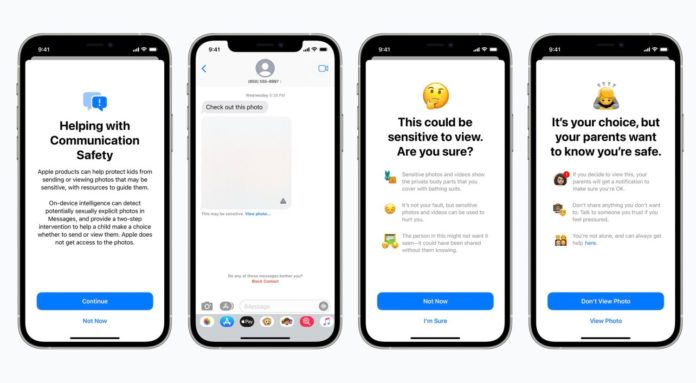

Az Apple a gyermekek bántalmazásának megállítása érdekében lerombolja az iPhone adatvédelmét. A vállalat azt tervezi, hogy a felhasználói fényképeket egy algoritmus segítségével szkenneli a gyermekekkel való bántalmazás bizonyítékaira. Ha ilyet talál, az algoritmus elküldi a fényképet egy emberi véleményezőnek. Az az elképzelés, hogy az Apple alkalmazottai figyelik a felhasználó gyermekeinek törvényes fényképeit, alapvetően aggasztó.

Nem sokkal a cikk közzététele után az Apple megerősítette, hogy létezik szoftvere, amely gyermekbántalmazásra vadászik. A „gyermekek kiterjesztett védelme” blogbejegyzésben a vállalat terveket fogalmazott meg a gyermekek szexuális bántalmazásával kapcsolatos anyagok (CSAM) visszaszorítása érdekében.

![]() Böngésszen tovább legfrissebb híreink között!

Böngésszen tovább legfrissebb híreink között!

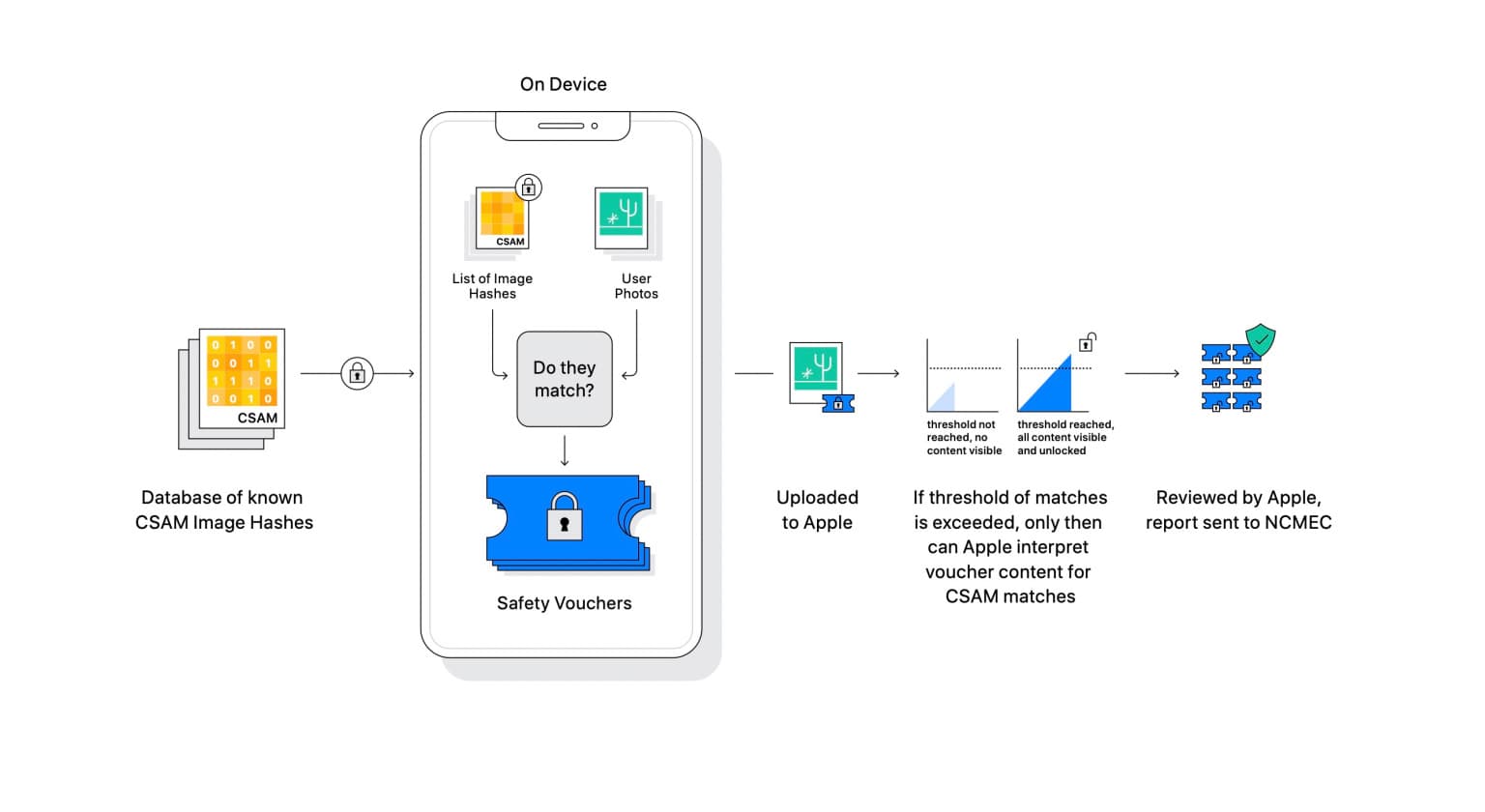

E tervek részeként az Apple új technológiát vezet be az iOS és az iPadOS rendszerben, amely „lehetővé teszi az Apple számára, hogy észlelje az iCloud Fotókban tárolt ismert CSAM képeket”. Lényegében az eszközön végzett szkennelés történik az iCloud Fotókban tárolt összes média esetében. Ha a szoftver azt találja, hogy egy kép gyanús, elküldi azt az Apple-nek, amely visszafejti a képet és megtekinti. Ha úgy találja, hogy a tartalom valójában illegális, értesíti a hatóságokat.

Az Apple azt állítja, hogy „évente egy az ezermilliárdhoz esély van egy adott fiók helytelen megjelölésére”.